Технології Deepfake стрімко розвиваються, стираючи межу між реальністю та вигадкою. Те, що колись було інструментом для голлівудських спецефектів, сьогодні стало доступним для широкого загалу, породжуючи нові виклики у сфері інформаційної безпеки. У цій статті ми детально розберемо, що таке діпфейки, як вони створюються, яку небезпеку несуть і, найголовніше, як навчитися їх розпізнавати, щоб не стати жертвою маніпуляцій. Про все це та багато іншого читайте далі на izaporizhets.com.

Що таке Deepfake і як це працює?

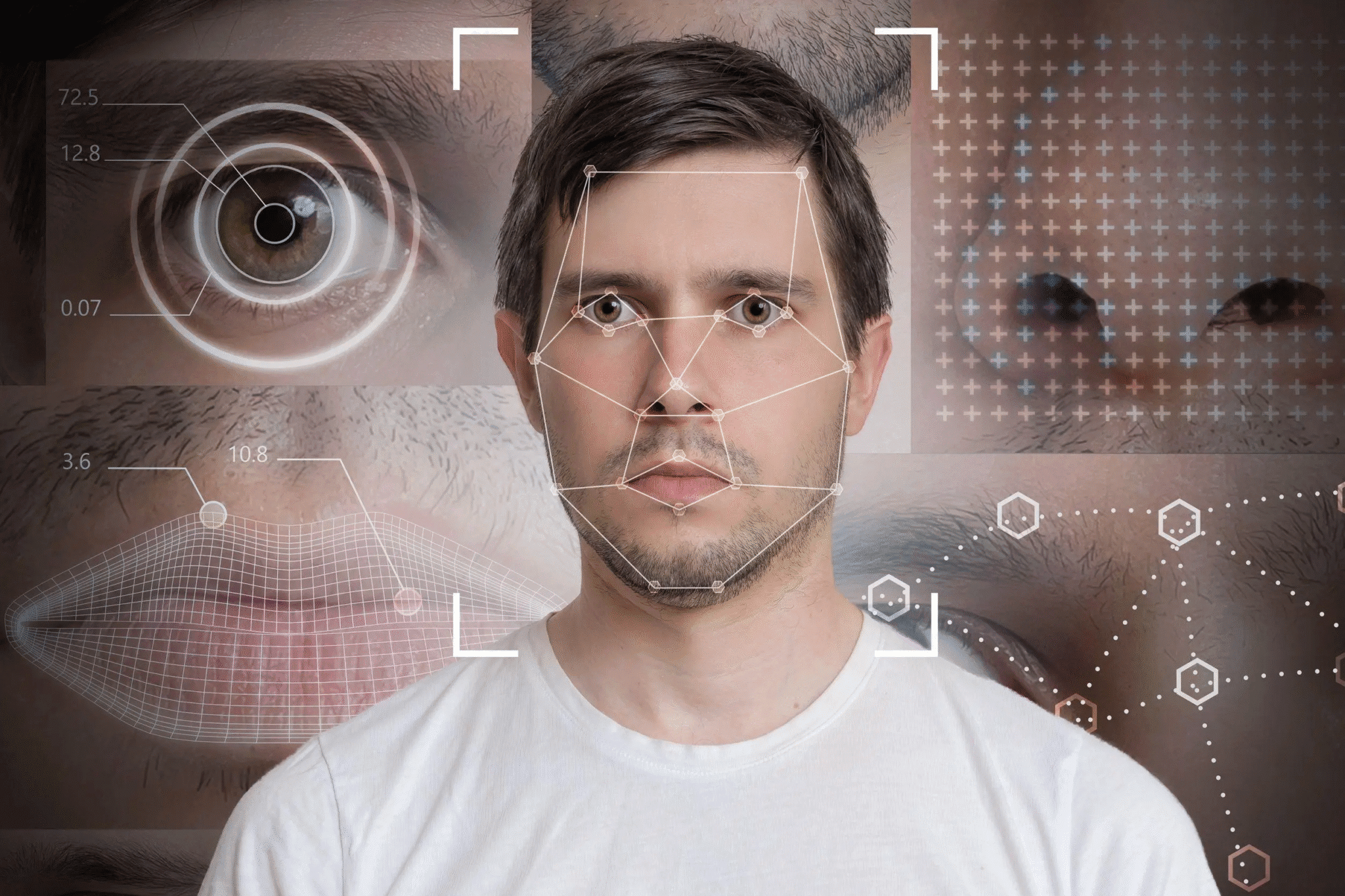

Deepfake (від англ. “deep learning” – глибоке навчання та “fake” – підробка) — це методика синтезу зображення, заснована на штучному інтелекті. Вона використовується для з’єднання та накладення існуючих зображень та відео на інші зображення або відеоролики. Простими словами, за допомогою спеціальних алгоритмів (генеративно-змагальних мереж, або GAN) можна замінити обличчя однієї людини на інше у відео, змусити її говорити те, чого вона ніколи не казала, або навіть створити повністю синтетичну особистість.

Процес створення діпфейку виглядає приблизно так:

- Збір даних: Для створення якісного діпфейку потрібна велика кількість фотографій та відео людини-“донора” (чиє обличчя буде “вкрадено”) та людини-“реципієнта” (на чиє тіло буде “накладено” обличчя). Чим більше матеріалу з різними ракурсами, освітленням та мімікою, тим реалістичнішим буде результат.

- Навчання нейромережі: Два алгоритми працюють у парі. Генератор намагається створити максимально реалістичне підроблене зображення. Дискримінатор, у свою чергу, вчиться відрізняти справжні зображення від підроблених, створених генератором. Вони “змагаються” між собою: генератор вдосконалюється, щоб обдурити дискримінатора, а дискримінатор стає все більш пильним. Цей процес, що нагадує біохакінг для мозку, дозволяє досягти вражаючої якості підробок.

- Синтез відео: Після завершення навчання модель здатна генерувати відео, де обличчя однієї людини замінено на іншу, зберігаючи при цьому оригінальну міміку, рухи губ та емоції.

Сфери застосування та потенційні загрози

Хоча технологія Deepfake має і позитивні застосування (наприклад, у кіноіндустрії для омолодження акторів або в освітніх проєктах), її потенціал для зловживань є величезним. Негативні наслідки можуть торкнутися кожного.

| Сфера | Потенційна загроза |

|---|---|

| Політика та суспільство | Створення фейкових відео з виступами політиків для маніпуляції громадською думкою, дискредитації опонентів, розпалювання ворожнечі та впливу на результати виборів. |

| Шахрайство | Створення діпфейків для видачі себе за іншу людину з метою отримання доступу до банківських рахунків, конфіденційної інформації або шантажу. |

| Репутаційні ризики | Використання технології для створення компрометуючих відео, що можуть зруйнувати кар’єру та особисте життя будь-якої людини. |

| Дезінформація та фейкові новини | Масове поширення підроблених відео для створення паніки, підриву довіри до ЗМІ та офіційних джерел інформації. |

Як розпізнати Deepfake: практичні поради

На щастя, ідеальних діпфейків поки що не існує. Навіть найпросунутіші алгоритми залишають сліди, які можна помітити при уважному аналізі. Ось на що варто звертати увагу:

1. Аналіз обличчя та міміки

- Невідповідність моргання: Люди моргають з певною частотою (в середньому раз на 2-10 секунд). Ранні версії діпфейків часто “забували” моргати. Хоча сучасні алгоритми це враховують, іноді частота моргання може бути неприродною – занадто частою або занадто рідкою.

- Неприродна міміка та емоції: Обличчя на відео може виглядати застиглим, “пластиковим”. Емоції можуть не відповідати контексту розмови. Звертайте увагу на синхронізацію рухів губ зі звуком.

- Артефакти на краях обличчя: Придивіться до контурів обличчя, особливо в районі шиї та волосся. Часто можна помітити розмиття, мерехтіння або неприродне накладення одного зображення на інше.

- Колір шкіри та освітлення: Відтінок шкіри обличчя може дещо відрізнятися від кольору шкіри на шиї та руках. Освітлення на обличчі може не відповідати загальному освітленню сцени.

2. Технічні деталі відео

- Якість відео: Часто діпфейки мають нижчу якість, ніж оригінальне відео. Це робиться для того, щоб приховати недоліки та артефакти. Будьте особливо підозрілими до коротких відео низької роздільної здатності.

- Невідповідність звуку: Звукова доріжка може бути несинхронізована з рухами губ. Голос може звучати роботизовано, без емоційних інтонацій, або мати дивні фонові шуми.

- Дивні рухи тіла: Алгоритми здебільшого фокусуються на обличчі, тому рухи тіла та голови можуть виглядати незграбними та неприродними.

Інструменти для перевірки та критичне мислення

Окрім візуального аналізу, важливо розвивати критичне мислення та використовувати доступні інструменти для перевірки інформації. Перш ніж поширювати сумнівне відео, поставте собі кілька запитань:

- Джерело інформації: Хто поширив це відео? Чи є це надійним джерелом? Перевірте, чи опублікували це відео офіційні сторінки особи чи організації, про яку йдеться.

- Емоційна реакція: Чи викликає відео у вас сильну емоційну реакцію (гнів, страх, обурення)? Маніпулятори часто намагаються грати на емоціях, щоб вимкнути критичне мислення.

- Пошук першоджерела: Спробуйте знайти оригінальне відео або новину на авторитетних ресурсах. Можливо, це відео вже було спростовано фактчекерами.

Розвиток технологій штучного інтелекту не стоїть на місці. Цікаво, що нейромережі та креативність йдуть пліч-о-пліч, створюючи не лише загрози, а й нові можливості для митців та розробників.

Майбутнє Deepfake та як захиститися

Технології Deepfake будуть лише вдосконалюватися, і розпізнати підробку неозброєним оком ставатиме все складніше. Тому боротьба з ними вимагає комплексного підходу:

- Розробка технологій детектування: Технологічні гіганти та дослідницькі інститути активно працюють над створенням інструментів, які зможуть автоматично виявляти діпфейки.

- Медіаграмотність: Підвищення рівня медіаграмотності населення є ключовим фактором у боротьбі з дезінформацією. Важливо навчати людей, особливо дітей та підлітків, критично оцінювати інформацію, яку вони споживають.

- Законодавче регулювання: Уряди багатьох країн розробляють закони, що передбачають відповідальність за створення та поширення шкідливих діпфейків.

Висновок: Технологія Deepfake — це потужний інструмент, який може бути використаний як на благо, так і на шкоду. У світі, де дезінформація поширюється з блискавичною швидкістю, вміння розпізнавати підроблені відео та критично мислити стає життєво необхідною навичкою. Будьте пильними, перевіряйте джерела та не дозволяйте маніпулювати собою. Ваша інформаційна гігієна — це ваш внесок у безпеку всього суспільства.